分析网站反复中毒如何选择合理解决方案

原创网站有一定影响力之后,就会面临各类病毒、木马,反复中毒情况严重的网站会被降权,甚至停止放出快照,恢复时间很长。特别是我们这类主打SEO内容输出的非盈利博客,用付费的杀毒软件、防火墙、插件觉着没必要,网站做来营销的公司才考虑用这种方法。

常说的中毒指的是篡改首页、跳转其他网站、挂黑链接等形式。有针对域名、服务器、内容管理系统CMS等方向。各种攻击手段复杂,吖七不是黑客,只能从自己遇到的诸多中毒情况给出应对方案。

篡改首页

现在遇到的篡改首页是修改标题(目标标题加联系电话),前端是无感的,因为影响的只是搜索引擎快照。由于不易被察觉,存在的时间更长。而直接跳转到其他网页的方式容易被管理人员察觉,或者从服务器的提醒信息得知,管理人员会手动处理。

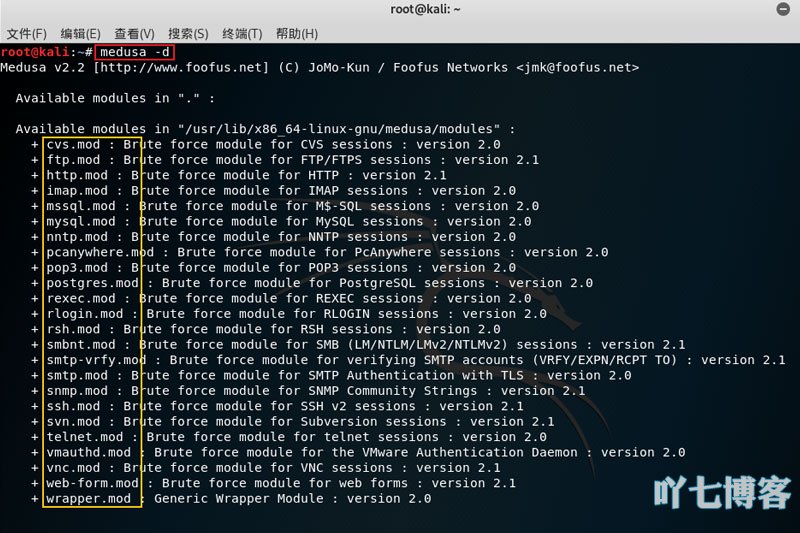

这种手段多是黑客利用机器无差别扫,确定网站使用的CMS程序,利用这些漏洞暴力破解,进行增删改查操作。

应对方案:及时更新CMS版本,同时打好服务器补丁。做好数据库、网站文件的备份,在中毒后第一时间还原,把损失降到最低。这种应对方案不会产生费用,打消耗战,对方觉得太麻烦转而攻击其他网站、服务器。

种木马留后门

用户发现中毒之后很难处理干净,木马程序可以利用某些文件夹权限问题,上传、复制病毒程序,路径很隐蔽,和所在文件夹文件名类似,一般需要通过专杀工具才能发现,根据某些特征筛选出来,站长检查无误再删除。

应对方案:阿里云的安全防护比较及时,一旦发现可以手动处理,能最大程度地减少不良影响。关闭FTP,把上传文件夹如 /uploads/ 权限设置为644不可执行php。

提升用户权限

黑客在网站上注册一个用户,一般为阅读者、游客,权限很低,一旦提升为网站CMS管理权限,就可以进行许多操作。做到这一步的前提一般需要攻破数据库,才能增删改查。

应对方案:数据库密码设置复杂一些,网站不再提供注册功能,甚至可以把注册功能删除。也可以保留黑客注册的账户名,把权限降到最低。大多都是用机器注册的,用户不能同名。

安装文件管理插件

大多数的CMS在WEB端登录后台,可以直接进行文件管理,这个功能容易被黑客利用,不用拿到太高权限,就能修改首页文件。

应对方案:删除文件管理功能或者删除安装插件功能。

利用快照发布信息

robots.txt 设置不好,容易泄露信息。发现有人访问你网站的 robots.txt 没有禁止动态链接抓取,就会利用网站的搜索功能,向百度提交这个带特点文字的搜索URL,如果 robots.txt 未禁止蜘蛛抓取该路径链接或动态链接,这些快照有一定几率展示出来,由于百度取消了举报快照功能,是很难删除的。

应对方案:非必要可以删除搜索功能,如果有需求,应该设置 robots.txt 禁止抓取搜索页面,并且把标题Title修改为固定。robots.txt 禁止搜索路径、动态路径抓取,参考文章《robots.txt屏蔽垃圾蜘蛛抓取网站信息》。

挂黑链接、发布文章等攻击,可以把模板文件夹下所有文件、首页 index.php 或 index.html 文件权限设为644,需要指出的是这样无法防止黑客直接覆盖这些文件,实在觉得影响严重的,可以购买阿里云、宝塔、Wordpress等的首页保护服务。

扩展阅读

本文地址:https://www.vi586.com/life/803.html

版权声明:原创文章,版权归重庆SEO吖七所有,欢迎分享本文,支持原创,转载请保留出处